Chapitre 6 Tests d’hypothèses sur deux échantillons

Il est très fréquent que l’on ait à comparer deux populations selon un critère quantitatif particulier. Par exemple:

- Comparer deux traitements médicaux au vu de leurs effets sur les patients.

- Comparer différents groupes d’étudiants au vu de leurs résultats scolaires.

- Comparer les fréquences d’occurrences de maladies chez les fumeurs et les non fumeurs.

Statistiquement, cela signifie que l’on dispose d’observations de variables aléatoires \(X_{11},X_{12},\ldots,X_{1n_1}\) i.i.d. constituant le premier échantillon, et de variables aléatoires \(X_{21},X_{22},\ldots,X_{2n_2}\) i.i.d. constituant le deuxième échantillon.

Comparer les deux échantillons revient à comparer les paramètres des lois de probabilité des \(X_{1}\) et des \(X_{2}\). Un test de comparaison de deux échantillons gaussiens indépendants consiste à supposer que les deux échantillons sont indépendants et de lois normales, et à comparer les moyennes et les variances de ces lois. Un test de comparaison de deux proportions consiste à supposer que les deux échantillons sont indépendants et de lois de Bernoulli, et à comparer les paramètres de ces lois. Un test de comparaison de deux échantillons gaussiens appariés consiste à supposer que les échantillons sont de lois normales, mais pas indépendants (en un certain sens) et à comparer les moyennes de ces lois. Il faut dans ce cas que les échantillons soient de même taille (ce dernier test n’est pas abordé dans ce cours).

6.1 Comparaison de deux échantillons gaussiens indépendants

Dans cette section, on supposera que les deux échantillons sont indépendants et de lois normales et comparera leurs moyennes et leurs variances. \(X_{11},X_{12},\ldots,X_{1n_1}\) sont supposées indépendantes et de même loi \(\mathcal{N}(m_1,\sigma_1^2)\) et \(X_{21},X_{22},\ldots,X_{2n_2}\) indépendantes et de même loi \(\mathcal{N}(m_2,\sigma_2^2)\). Les \(X_{1}\) et \(X_{2}\) sont indépendantes. Les moyennes empiriques et variances estimées de deux échantillons sont notées respectivement \(\overline{X}_{1}, S_1^2, {S_1^*}^2, \overline{X}_{2}, S_2^2\) et \({S_2^*}^2\).

Exemple 6.1 Deux groupes d’étudiants de tailles respectives \(n_1 = 25\) et \(n_2 = 31\) ont suivi le même cours de statistique et passé le même examen. Les moyennes et écarts-types empiriques des notes obtenues dans les deux groupes sont respectivement:

\[ \begin{array}{ll}{\text { Premier groupe: }} & {\overline{x}_{{1}}=12.8, \quad s_{1}^{*}=3.4} \\ {\text { Deuxième groupe : }} & {\overline{x}_{{2}}=11.3, \quad s_{2}^{*}=2.9}\end{array} \]

On suppose que les notes sont réparties dans les deux groupes selon des lois normales et qu’elles sont toutes indépendantes. Peut-on considérer que le premier groupe est meilleur que le deuxième, c’est-à-dire qu’un point et demi d’écart entre les moyennes est significatif d’une différence de niveau? La procédure à suivre consiste à tester d’abord l’égalité des variances, puis l’égalité des moyennes.6.1.1 Test de Fisher de comparaison des variances

Comparer les variances des deux échantillons, c’est tester

\[ H_{0}: \sigma_1^2=\sigma_2^2 \text { contre } H_{1}: \sigma_1^2\neq\sigma_2^2 \] Pour tester cette hypothèse on utilise la statistique

\[ F_0 = \frac{{S_1^*}^2}{{S_2^*}^2} \]

Cette statistique suit la loi \(F\) de Fisher, avec \(n_1-1\) et \(n_2-1\) degrés de liberté si l’hypothèse \(H_0\) est vraie. (preuve )

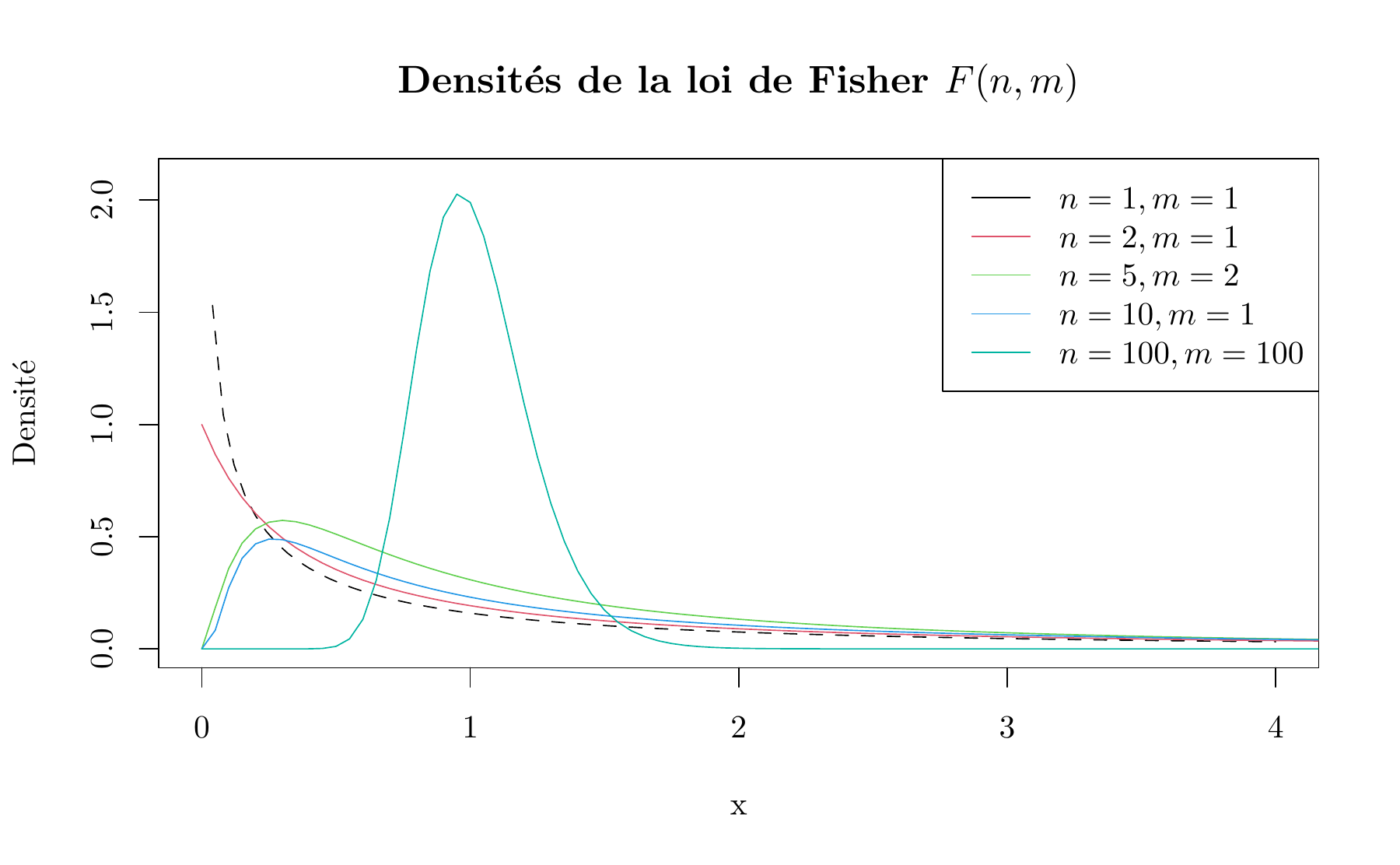

Rappel de la définition de la loi de Fisher: Soit \(U\) et \(V\) deux variables aléatoires indépendantes suivant une loi de \(\chi^2\) respectivement à \(n\) et \(m\) degrés de liberté. On dit que \(F= \frac{U/n}{V/m}\) suit une loi de Fisher-Snedecor à \((n,m)\) degrés de liberté. \(F \thicksim \mathcal{F}(n,m)\)

Figure 6.1: Densités de la loi de Fisher \(F(n,m)\)

La procédure pour le test bilatéral

Pour tester

\[ H_{0}: \sigma_1^2=\sigma_2^2 \text { contre } H_{1}: \sigma_1^2\neq\sigma_2^2 \] On calcule

\[ f_0 = \frac{{s_1^*}^2}{{s_2^*}^2} \]

Critère de rejet de \(H_{0}: \sigma_1^2=\sigma_2^2\)

On rejette \(H_{0}: \sigma_1^2=\sigma_2^2\) si

\[f_0 > f_{1-\alpha/2; \, n_1-1,n_2-1} \quad \text{ ou } \quad f_0 < f_{\alpha/2; \, n_1-1,n_2-1}\]

où \(f_{\alpha/2; \, n_1-1,n_2-1}\) et \(f_{1-\alpha/2; \, n_1-1,n_2-1}\) sont les quantiles d’ordre \(\alpha/2\) et \(1-\alpha/2\) de la loi de Fisher \(F\) avec \(n_1-1\) et \(n_2-1\) degrés de liberté.

Plusieurs tables de la loi de Fisher (selon la valeur de \(\alpha\)) se trouvent dans l’annexe F.

Remarque: Ces tables ne donnent que les quantiles de l’aile supérieure de la loi \(F\), de sorte que pour trouver \(f_{\alpha/2; \, n_1-1,n_2-1}\) on doit utiliser l’égalité

\[ f_{\alpha/2; \, n_1-1,n_2-1} = \frac{1}{f_{1-\alpha/2; \, n_2-1,n_1-1}} \]

Dans l’exemple 6.1, \({s_{1}^{*}}^2 > {s_{2}^{*}}^2\) et \(\frac{{s_{1}^{*}}^2}{{s_{2}^{*}}^2} = 1.37\). Selon la table de la loi de Fisher dans l’annexe F, au seuil \(\alpha=5\%\), \(f_{1-0.025; \, 24,30}=2.14\). On trouve que \(f_0 = \frac{{s_{1}^{*}}^2}{{s_{2}^{*}}^2}=1.37 < f_{1-0.025; \, 24,30}=2.14\) donc on n’est pas dans la région de rejet de \(H_0\). On ne peut pas donc conclure que les variances des deux échantillons sont différentes.

Des deux rapports \(\frac{{s_1^*}^2}{{s_2^*}^2}\) et \(\frac{{s_2^*}^2}{{s_1^*}^2}\), un seul est plus grand que \(1\). Or on peut montrer que pour \(\alpha < 1/2\), \(f_{1-\alpha; \, n,m} > 1\). Donc, pour la règle de décision du rejet de \(H_0\), il suffit de retenir celui des deux rapports qui est supérieur à \(1\).

La procédure pour les tests unilatéraux

On peut utiliser la même statistique pour tester les hypothèses alternatives unilatérales. Comme la notation \(X\) et \(Y\) est arbitraire, on suppose que la population \(X\) a la plus grande variance. Donc les hypothèses du test unilatéral sont

\[ H_{0}: \sigma_1^2=\sigma_2^2 \text { contre } H_{1}: \sigma_1^2 > \sigma_2^2 \] On rejette donc \(H_0:\sigma_1^2=\sigma_2^2\) si

\[ f_0 > f_{1-\alpha; \, n_1-1,n_2-1} \]

6.1.2 Tests de comparaison de moyennes

Dans cette section, nous introduisons les tests sur les moyennes de deux distributions normales avec variances connues et inconnues.

6.1.2.1 Cas de variances connues

Supposons que \(X_1\) et \(X_2\) sont normalement distribuées ou, si elle ne le sont pas, que les conditions du théorème central limite s’appliquent.

Comparer les moyennes de deux échantillons, c’est tester

\[ H_{0}: m_1 = m_2 \text { contre } H_{1}: m_1 \neq m_2 \]

La procédure de ce test repose sur la distribution de la différence des moyennes des échantillons, \(\overline{X}_1 - \overline{X}_2\). On peut résumer la situation ainsi:

| Populations | \(X_1 \thicksim \mathcal{N}(m_1,\sigma_1^2)\) | \(X_2 \thicksim \mathcal{N}(m_2,\sigma_2^2)\) |

| Echantillons | \(X_{11},X_{12},\ldots,X_{1n_1}\) | \(X_{21},X_{22},\ldots,X_{2n_2}\) |

| Loi des moyennes empiriques | \(\overline{X}_1 \thicksim \mathcal{N}(m_1,\sigma_1^2/n_1)\) | \(\overline{X}_2 \thicksim \mathcal{N}(m_2,\sigma_2^2/n_2)\) |

| Loi de la différence des moyennes empiriques | \(\overline{X}_1 - \overline{X}_2 \thicksim \mathcal{N}\big(m_1-m_2,\frac{\sigma_1^2}{n_1} + \frac{\sigma_2^2}{n_2}\big)\) |

Donc, si l’hypothèse nulle \(H_0: m_1=m_2\) est vraie, la statistique du test

\[\begin{equation} Z_0 = \frac{\overline{X}_1 -\overline{X}_2}{\sqrt{\frac{\sigma_1^2}{n_1} + \frac{\sigma_2^2}{n_2}}} \tag{6.1} \end{equation}\]

suit la loi \(\mathcal{N}(0,1)\).

Critère de rejet de \(H_{0}\):

- Test de \(H_0: m_1 = m_2\) contre \(m_1 \neq m_2\): On rejette \(H_0\) si \(|z_0| > z_{1-\alpha/2}\).

- Test de \(H_0: m_1 \leq m_2\) contre \(m_1 > m_2\): On rejette \(H_0\) si \(z_0 > z_{1-\alpha}\).

- Test de \(H_0: m_1 \geq m_2\) contre \(m_1 < m_2\): On rejette \(H_0\) si \(z_0 < z_{\alpha}\).

où \(z_{\alpha}\) est le quantile d’ordre \(\alpha\) de la loi \(\mathcal{N}(0,1)\).

6.1.2.2 Cas de variances inconnues mais égales \(\sigma_1^2=\sigma_2^2=\sigma^2\) (test de Student)

Les variances \(\sigma_1^2\) et \(\sigma_2^2\) étant inconnues, on ne peut pas utiliser directement la statistique de l’équation (6.1) pour construire le test. Comme dans ce cas, \({S_1^*}^2\) et \({S_2^*}^2\) estiment tous les deux la variance commune \(\sigma^2\), on peut les combiner pour obtenir une seule estimation de \(\sigma^2\), soit

\[ S_p^2 = \frac{(n_1-1){S_1^*}^2 + (n_2-1){S_2^*}^2}{n_1+n_2-2} \]

Pour tester \(H_0:m_1=m_2\), on calcule la statistique du test

\[ T_0 = \frac{\overline{X}_1 -\overline{X}_2}{S_p \sqrt{\frac{1}{n_1} + \frac{1}{n_2}}} \]

Cette statistique, sous \(H_0\) suit la loi de Student avec \(n_1+n_2-2\) degrés de libertés \(St(n_1+n_2-2)\).

Critère de rejet de \(H_{0}\):

- Test de \(H_0: m_1 = m_2\) contre \(m_1 \neq m_2\): On rejette \(H_0\) si \(|t_0| > t_{1-\alpha/2; \, n_1+n_2-2}\).

- Test de \(H_0: m_1 \leq m_2\) contre \(m_1 > m_2\): On rejette \(H_0\) si \(t_0 > t_{1-\alpha; \, n_1+n_2-2}\).

- Test de \(H_0: m_1 \geq m_2\) contre \(m_1 < m_2\): On rejette \(H_0\) si \(t_0 < t_{\alpha; \, n_1+n_2-2}\).

où \(t_{\alpha; \, n}\) est le quantile d’ordre \(\alpha\) de la loi \(St(n)\).

6.1.2.3 Cas de variances inconnues mais inégales

A priori, si le test de Fisher rejette l’égalité des variances, on ne peut pas appliquer le test sur les moyennes. En fait, le théorème central limite permet de montrer que, si \(n_1\) et \(n_2\) sont suffisamment grands (supérieurs à 30), alors la loi de \(T_0\) est approximativement la loi \(\mathcal{N}(0,1)\) même si les deux variances sont différentes et en fait même si les deux échantillons ne sont pas de loi normale.

Par conséquent, si on a beaucoup d’observations, le test de Student permet de comparer les moyennes d’échantillons issus de n’importe quelle loi de probabilité. En revanche, si on a peu d’observations, ce test ne fonctionne pas. On utilise alors d’autres tests16.

La généralisation de ce problème à la comparaison des moyennes de \(k\) échantillons gaussiens indépendants fait l’objet d’un domaine important de la statistique appelé l’analyse de variance (Anova).

6.2 Comparaison de deux proportions

Dans cette section, on supposera que les deux échantillons sont indépendants et de loi de Bernoulli et on comparera leurs paramètres. \(X_{11},X_{12} \ldots, X_{1n_{1}}\) sont indépendantes et de même loi \(\mathcal{B}\left(p_{1}\right)\) et \(X_{21},X_{22} \ldots, X_{2n_{2}}\) indépendantes et de même loi \(\mathcal{B}\left(p_{2}\right) .\) Les \(X_{1}\) et les \(X_{2}\) sont indépendantes. On souhaite comparer \(p_{1}\) et \(p_{2}\), c’est-à-dire effectuer des tests du type \(p_{1} \leq p_{2}\) contre \(p_{1}>p_{2}\) ou \(p_{1}=p_{2}\) contre \(p_{1} \neq p_2\).

Comme pour les tests sur une propotion vus dans le chapitre précédent, ce test est valable lorsque \(n_1\) et \(n_2\) sont suffisamment grands.

Supposons que l’approximation normale de la loi binomiale s’applique à chaque population, de sorte que les estimations des proportions \(\hat{p}_1=\sum_{i=1}^{n_1}X_{1i}/ {n_1}\) et \(\hat{p}_2=\sum_{j=1}^{n_2}X_{2j}/ {n_2}\) suivent approximativement les lois normales:

\[ \hat{p}_1 \thicksim \mathcal{N}\big(p_1, \frac{p_1(1-p_1)}{n_1}\big) \quad \text{ et } \quad \hat{p}_2 \thicksim \mathcal{N}\big(p_2, \frac{p_2(1-p_2)}{n_2}\big) \]

Donc, si l’hypothèse nulle \(H_0\) est vraie, en utilisant le fait que \(p_1=p_2=p\), la variable aléatoire \(\hat{p}_1-\hat{p}_2\) suit approximativement la loi normale:

\[ \hat{p}_1-\hat{p}_2 \thicksim \mathcal{N}\big(0, p(1-p) \big[ \frac{1}{n_1} + \frac{1}{n_2} \big] \big) \]

Un estimateur du paramètre commun17 \(p\) (qu’on pourrait appeler la “proportion du succès global”) est:

\[ \hat{p} = \frac{\sum_{i=1}^{n_1} X_{1i} + \sum_{j=1}^{n_2} X_{2j}}{n_1+n_2} \]

La statistique du test pour \(H_0: p_1=p_2\), qui suit une loi \(\mathcal{N}(0,1)\) lorsque \(H_0\) est vraie, est alors

\[ Z_0 = \frac{\hat{p}_1-\hat{p}_2}{\sqrt{ \hat{p}(1-\hat{p}) \big[ \frac{1}{n_1} + \frac{1}{n_2} \big]}} \]

Critère de rejet de \(H_{0}\):

- Test de \(H_0: p_1 = p_2\) contre \(p_1 \neq p_2\): On rejette \(H_0\) si \(|z_0| > z_{1-\alpha/2}\).

- Test de \(H_0: p_1 \leq p_2\) contre \(p_1 > p_2\): On rejette \(H_0\) si \(z_0 > z_{1-\alpha}\).

- Test de \(H_0: p_1 \geq p_2\) contre \(p_1 < p_2\): On rejette \(H_0\) si \(z_0 < z_{\alpha}\).

où \(z_{\alpha}\) est le quantile d’ordre \(\alpha\) de la loi \(\mathcal{N}(0,1)\).